快訊

- 【MWC 20年】6G、衛星6大重點搶先看! 高通CEO領軍火力全開、聯發科首登大會演講

- 【MWC 20年】巴賽隆納69億經濟商機起飛! 全城覆蓋F1加泰隆尼亞賽道助陣

- 北市醫美診所槍擊案 槍手今晚移送北檢 冷眼直視記者

- 落跑無門!北檢今晚啟動防逃機制 消防署前署長黃季敏遭拘提即刻發監

- 美伊日內瓦談判中場休息 伊朗阿曼稱會談「具建設性、富創意且積極」

- 淫魔艾普斯坦檔案再擊沉一人 世界經濟論壇執行長下台

- 近10年首見!北韓勞動黨大會辦閱兵 未展示任何武器

- 高鐵、台鐵「台北站炸彈殺人」恐嚇留言連發 警力動員巡查各站

- 中國人大常委會議結束 仍舊沒解除張又俠與劉振立人大職位

- 一邊談判一邊研究打擊手段 美國官員:「斬首行動」是選項

- 風電3-3選商訂「在地產業經濟效益」分數踩WTO紅線?能源署表態了

- WSJ:華郵近3年虧掉87億元 導致大裁員決定

- 228連假首日「車流估1.2倍」 10大壅塞路段曝光

- 達發打入一線低軌衛星供應鏈! 股價先奔漲停

- 激辯!檢察官搬5大罪狀轟陳尚潔「讓剴剴等到死」 律師駁:別懲罰行善者

- 停車場、避難空間違規使用 擬按最高稅率恐遭課4.8%房屋稅

- 是方去年EPS 15.75元 擬配14.2元現金! 將祭庫藏股穩軍心再攀高峰

- 蔣萬安育兒政策惹議!范雲控藍白擋預算 藍黨團:元凶是民進黨

- 認定賴苡任傷黨形象、陳重文涉貪一審有罪 藍北市黨部:建議黨中央黨紀處分

- 盟友先上?美媒:美國希望以色列先出手打伊朗、以取得正當打擊理由

【財經一點通】AI總是記不住你的話!儲存產業定位自此顛覆 贏家條件不再只看GPU

2026-01-08 16:04 / 作者 Fomo研究院

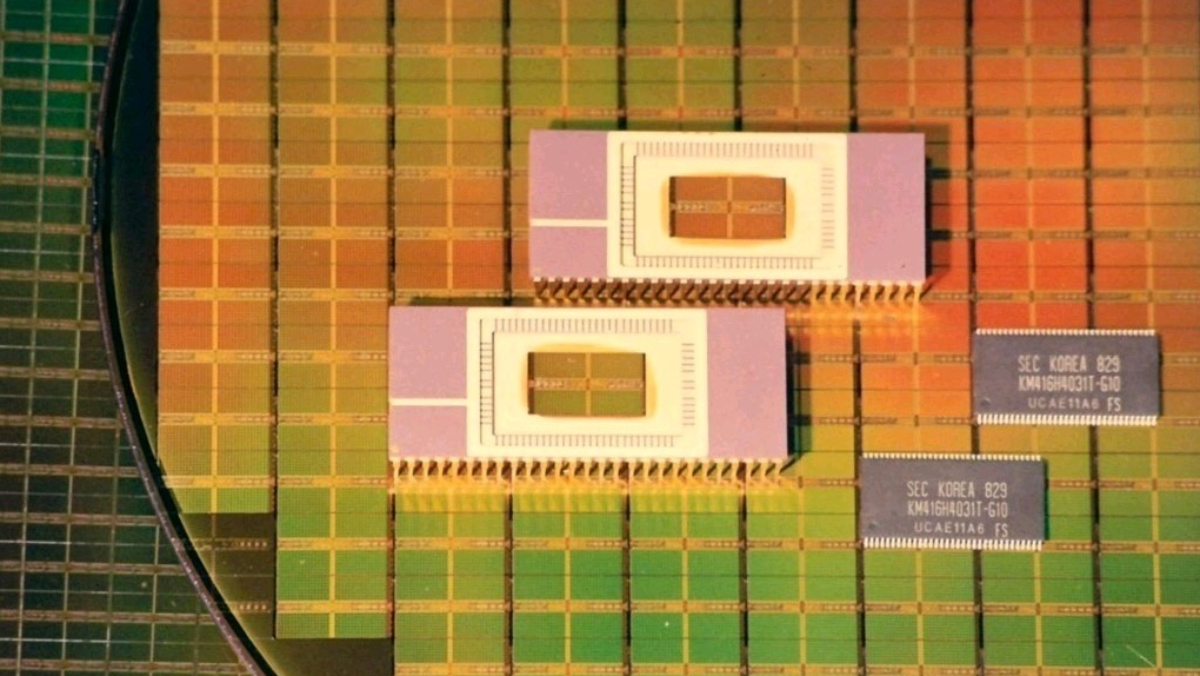

記憶體近來成了當紅炸子雞。圖為三星64Mb SDR SDRAM當年被應用於輝達首款GPU「GeForce 256」之上。業者提供

大家在用AI的時候,有沒有發現一個問題,AI總是很容易忘記你說過的話。

這正是黃仁勳在週一CES演講中點出的核心痛點,他說到:「儲存是一個至今完全未被服務的市場。」這句話,不僅讓SanDisk一晚暴漲 28%,更宣告了儲存產業從「配角」變成了「主角」。

隨著模型從數十億參數暴增至數兆,特別是需要進行多輪推理、具備長期記憶的「AI代理」(Agentic AI)成為主流,AI開始得了一種昂貴的「健忘症」。

在LLM(大語言模型)的推理過程中,有一個東西叫KV Cache(鍵值快取)。你可以把它想像成AI的「短期記憶」或「工作筆記」。

當你跟AI對話時,它不是一次性讀完所有資訊,而是逐字生成。為了保持對話的連貫性,AI必須把之前的對話背景(Context)存儲在GPU的HBM(高頻寬記憶體)裡。

當記憶體滿了,AI就得丟掉一部分舊的對話紀錄,如果之後又需要用到,就得重新計算一次,導致延遲暴增、效率崩潰。

這就像一個人的大腦工作區太小,無法同時記住一本小說的所有情節,只能不斷翻頁,甚至忘記前面角色的名字。

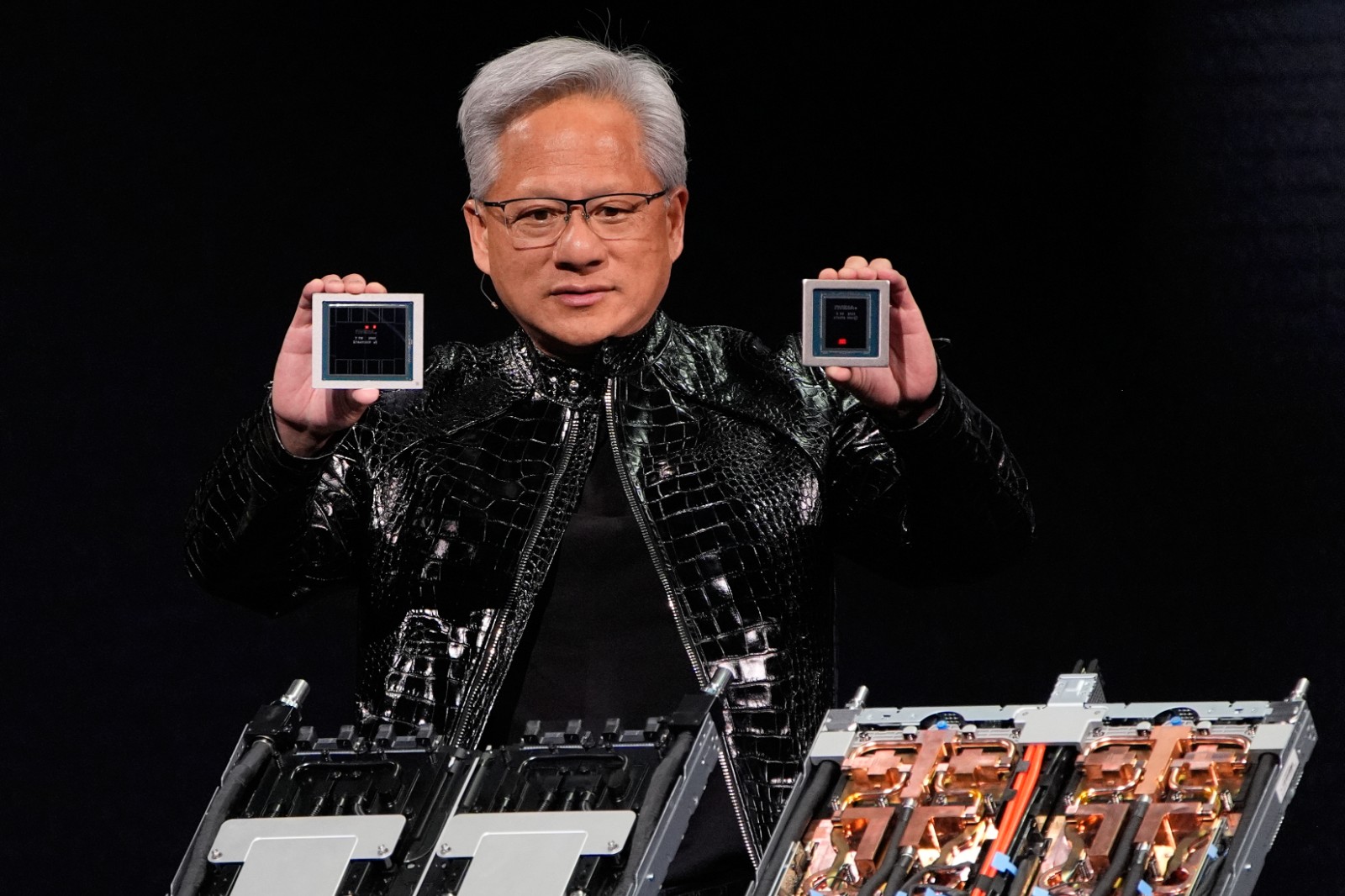

輝達執行長黃仁勳在CES展示Rubin GPU及Vera CPU。美聯社

面對這個瓶頸,黃仁勳發布了名為「推論上下文記憶體儲存平台」(Inference Context Memory Storage Platform)的架構。

這套架構的核心思想是:既然大腦(GPU記憶體)不夠用,那就給它外掛一個超大容量、反應又足夠快的「筆記本」。

而這個「筆記本」,就是過去被我們視為「冷倉庫」的NAND Flash快閃記憶體(SSD)。

Nvidia在傳統的記憶體層級中,硬是切出了一個全新的「Tier G3.5」:

- G1 (HBM): 當下的思考(Hot Context)。

- G2/G3 (DRAM/本地 SSD): 緩衝與短期暫存。

- ★ G3.5 (ICMS/NAND Flash): 「AI代理的長期記憶」。它利用乙太網路連接Flash儲存,存放那些隨時可能被重新調用的上下文。

- G4 (冷儲存): 傳統的封存檔案。

這一步,徹底顛覆了儲存產業的價值定位。它在運算架構中的地位,從一個不太重要的「儲物櫃」,躍升為大腦皮層的一部分。

黃仁勳甚至預言,這將成為「全球最大的儲存市場,基本上儲存了全世界AI的工作記憶」。

SanDisk記憶體示意圖。取自pexels

你可能會問,為什麼美光(Micron)漲了10%,而SanDisk卻能暴漲27%?有兩個原因:

1. 從「水桶」到「大腦」的價值重估:

過去,投資人認為SanDisk就是個賣「水桶」的,一個利潤微薄的商品化生意。黃仁勳的發言,等於是宣告這個「水桶」現在是「大腦」的一部分,其價值和需求量迎來了指數級的成長。

2. 「純粹性」的溢價:

SanDisk在2025年從西數(Western Digital)拆分後,成為了市場上唯一的純NAND Flash標的。

這次發表不只是技術更新,更是一場「結盟大會」。Nvidia透過制定規則,制定了周邊玩家的遊戲規則:

-它告訴Dell、HPE、Pure Storage等合作夥伴:以後AI工廠的儲存要按我的「G3.5」標準來蓋。

-它讓儲存不再只是「存數據」,而是要參與「搬運記憶」。

當內存(Memory)與儲存(Storage)的邊界消失時,未來的贏家,不是只看誰的GPU最多,而是看誰能以最快速度、最低功耗,在數萬個GPU之間「調度記憶」。

本文由臉書粉專「Fomo研究院」授權提供

最新more>

- 【MWC 20年】6G、衛星6大重點搶先看! 高通CEO領軍火力全開、聯發科首登大會演講

- 【MWC 20年】巴賽隆納69億經濟商機起飛! 全城覆蓋F1加泰隆尼亞賽道助陣

- WBC》徐若熙一軍初登板時間未定 小久保監督點出他的價值

- WBC》王者軟銀連續完封日本隊及台灣隊 小久保點出無法比較原因

- WBC》徐若熙飆158公里火球!小久保監督狂讚「是日本隊非常強勁的對手」

- 北市醫美診所槍擊案 槍手今晚移送北檢 冷眼直視記者

- 落跑無門!北檢今晚啟動防逃機制 消防署前署長黃季敏遭拘提即刻發監

- 美伊日內瓦談判中場休息 伊朗阿曼稱會談「具建設性、富創意且積極」

- 淫魔艾普斯坦檔案再擊沉一人 世界經濟論壇執行長下台

- 近10年首見!北韓勞動黨大會辦閱兵 未展示任何武器

熱門more>

- 3個小孩的爸!貪污檢察官林渝鈞表現曝光 檢察總長邢泰釗:令人痛心

- 8台星登央視春晚合唱〈寶島戀歌〉、他牽花蓮小女孩上台!伊能靜喊:中國台灣會感動

- 躲金主追債 劣檢林渝鈞竟拖行李住進基檢辦公室

- 檢辦當避風窩!劣檢「穿內褲亂晃」 前妻是酒國名花、半夜還私會俏麗女工友

- 北極熊幼崽遭格殺前最後凝視 猛虎界「黑暗騎士」入圍攝影獎

- 見剴剴遺體竟沒察覺兒虐!兒盟社工顫抖喊惡保母「演得好真」 法官問到她語塞

- 猴媽下巴多一張臉、穿山甲媽拿命換寶寶 攝影獎親子照揪感心

- 沉默癌症!吳中純淋巴癌驟逝 3身體警訊「無痛腫塊」要特別當心

- 大港開唱不讓人活了!《芙利蓮》神曲女歌手milet參戰 網樂翻:不講武德

- 台股萬元股王誕生37檔千金股助威! 00981A抓緊20檔一起飛